인공지능을 연구하는 비영리단체 오픈에이아이(OpenAI)가 개발한 AI 문장 생선기 GPT-2는 고정밀 문장을 자동 생성할 수 있어 개발팀이 너무 위험하다는 우려를 표명해 논문 공개를 연기하는 사태가 발생하기도 했다. 그런데 이런 GPT-2 학습에 이용하는 아키텍처를 직접 적용해 자동으로 이미지를 생성하는 기술이 개발되고 있다.

특정 영역에서 학습시킨 모델을 다른 영역으로 옮기는 기술을 전이 학습이라고 부른다. GPT-2는 이런 전이 학습 모델로 큰 성공을 거뒀다. 인간이 관여하지 않고 문장을 생성하는 GPT-2 외에도 구글 BERT, 페이스북 RoBERTa 등으로 상당한 발전을 이룬 것. 한편 자연어 분야에선 전이 학습 모델 성공은 놀랍지만 지금까지 이미지에서 전이 학습 모델을 위한 강력한 기능은 생성되지 못해왔다.

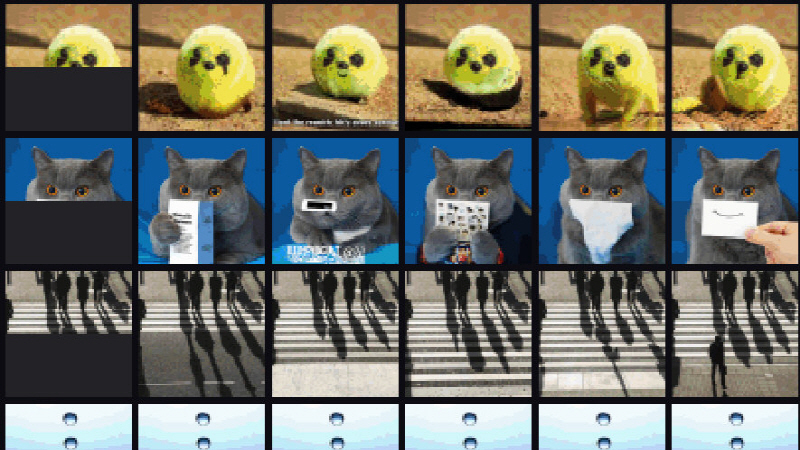

오픈에이아이가 새로 GPT-2와 같은 전이 학습 모델 샘플과 완제품으로 이미지에 일관성을 갖도록 픽셀 시퀀스를 훈련시키는 시도를 했다. 이는 인간이 절반 이미지를 주는 것만으로 모델이 이미지를 완성시키는 기술이다.

오픈에이아이는 7,600만 매개변수를 가진 iGPT-S, 4억 5,500만 파라미터를 가진 iGPT-M, 14억 파라미터를 가진 iGPT-L 등 3가지 버전 GPT-2 모델을 이미지넷(ImageNet)에서 훈련시켰다. 또 동시에 68억 파라미터를 가진 iGPT-XL을 이미지넷과 인터넷 이미지를 이용해 훈련시켰다. 각각 모델은 이미지 해상도를 줄이고 픽셀을 표현하는 9비트 고유 팔레트를 만들고 정확성을 손상시키지 않고 표준 RGB 스펙트럼 표준보다 3배 짧은 입력 시퀀스를 생성했다.

오픈에이아이에 따르면 모델 규모를 확대해 더 많은 반복 훈련을 해 이미지 품질을 향상시켜 벤치마크에서 좋은 결과를 보였다고 한다. 다만 iGPT 모델은 저화질 이미지가 생성된다거나 훈련 데이터 편견을 받는다는 등 제한이 있어 어디까지나 개념 증명 데모로 기능하는 정도다. 연구팀은 연구 결과가 컴퓨터비전과 언어 이해 기술 사이의 격차를 해소하는 작지만 중요한 단계라고 설명한다. 관련 내용은 이곳에서 확인할 수 있다.